InfiniBand é uma tecnologia de transferência de dados de alta velocidade que permite comunicação rápida e eficiente entre servidores, dispositivos de armazenamento e outros sistemas de computação. Ao contrário da Ethernet, uma tecnologia de rede popular para redes locais (LANs), o InfiniBand foi explicitamente projetado para conectar servidores e clusters de armazenamento em ambientes de computação de alto desempenho (HPC).

O InfiniBand usa uma arquitetura de duas camadas que separa as camadas física e de link de dados da camada de rede. A camada física usa links seriais de alta largura de banda para fornecer conectividade ponto a ponto direta entre os dispositivos. Em contraste, a camada de enlace de dados lida com a transmissão e recepção de pacotes de dados entre os dispositivos.

A camada de rede fornece os recursos críticos do InfiniBand, incluindo virtualização, qualidade de serviço (QoS) e acesso remoto direto à memória (RDMA). Esses recursos tornam o InfiniBand uma ferramenta poderosa para cargas de trabalho HPC que exigem baixa latência e alta largura de banda.

Leitura recomendada: EPON, uma tecnologia de acesso Ethernet de longa distância baseada em uma rede de transporte de fibra óptica

Um dos recursos críticos do InfiniBand é sua alta largura de banda. O InfiniBand pode suportar taxas de transferência de dados de até 200 Gigabits por segundo (Gbps), significativamente mais rápido do que as tecnologias de rede tradicionais, como Ethernet.

O InfiniBand também oferece suporte a QoS, priorizando o tráfego e alocando recursos de largura de banda conforme necessário. Isso garante que cargas de trabalho críticas recebam a largura de banda necessária e que cargas de trabalho não críticas não consumam mais do que seu compartilhamento justo de recursos.

Outro recurso essencial do InfiniBand são seus recursos de virtualização. O InfiniBand oferece suporte à criação de pistas virtuais, que fornecem uma maneira de particionar a rede para que diferentes cargas de trabalho possam ser isoladas. Isso permite que várias cargas de trabalho sejam executadas na mesma rede InfiniBand sem interferir umas nas outras.

A arquitetura InfiniBand é baseada em uma abordagem em camadas que separa as camadas física, de link de dados e de rede. A camada física fornece a conectividade física entre os dispositivos, enquanto a camada de enlace de dados lida com a transmissão e recepção de pacotes de dados.

A camada de rede fornece os recursos críticos do InfiniBand, incluindo RDMA. O RDMA oferece uma maneira de um dispositivo acessar a memória de outro dispositivo diretamente, sem a necessidade de software ou hardware intermediário. Isso elimina a necessidade de copiar dados entre dispositivos, o que pode reduzir significativamente a latência e aumentar o desempenho.

A arquitetura InfiniBand também inclui o conceito de switches, que são usados para conectar vários dispositivos. Os switches InfiniBand são projetados para fornecer conectividade de baixa latência e alta largura de banda entre dispositivos, tornando-os ideais para cargas de trabalho HPC.

Embora a Ethernet seja uma tecnologia de rede popular para LANs, ela não foi projetada para os requisitos de alto desempenho das cargas de trabalho HPC. A Ethernet normalmente tem maior latência e menor largura de banda do que a InfiniBand, tornando-a menos adequada para cargas de trabalho com uso intensivo de dados.

Além disso, a Ethernet não oferece suporte a recursos como QoS e RDMA, que são essenciais para cargas de trabalho HPC que exigem baixa latência e alta largura de banda.

RDMA é um recurso crucial do InfiniBand que fornece uma maneira de os dispositivos acessarem a memória de outros dispositivos diretamente. Com RDMA, os dados podem ser transferidos entre máquinas sem software ou hardware intermediário, reduzindo significativamente a latência e aumentando o desempenho.

O RDMA no InfiniBand é implementado usando um processo de duas etapas. Primeiro, o dispositivo emissor envia uma mensagem ao dispositivo receptor solicitando acesso à sua memória. O dispositivo receptor então concede acesso à sua memória e devolve uma carta ao remetente. Uma vez concedido o acesso, o remetente pode ler ou escrever diretamente na memória do dispositivo receptor.

O RDMA é particularmente útil para cargas de trabalho HPC que exigem baixa latência, pois elimina a necessidade de copiar dados entre dispositivos, o que pode introduzir latência adicional. O RDMA também pode reduzir a utilização da CPU descarregando tarefas de transferência de dados para o hardware da rede, liberando recursos da CPU para outras tarefas.

À medida que cresce a demanda por velocidades de transferência de dados mais rápidas, os sistemas de rede InfiniBand se tornaram uma solução cada vez mais popular para data centers. Com suas conexões de alta velocidade, o InfiniBand é uma excelente escolha para aplicativos que exigem baixa latência e alto rendimento.

Um dos elementos críticos de um sistema de rede InfiniBand são seus switches. Os switches InfiniBand são responsáveis pelo roteamento de dados entre dispositivos conectados à rede. Esses switches funcionam na camada física da rede, transmitindo dados na maior velocidade possível.

Os switches InfiniBand vêm em vários tamanhos e configurações, desde pequenos botões para conectar servidores individuais até grandes switches para criar clusters de alto desempenho. Eles também possuem recursos de qualidade de serviço (QoS), que permitem aos administradores priorizar o tráfego e gerenciar os recursos de rede com eficácia.

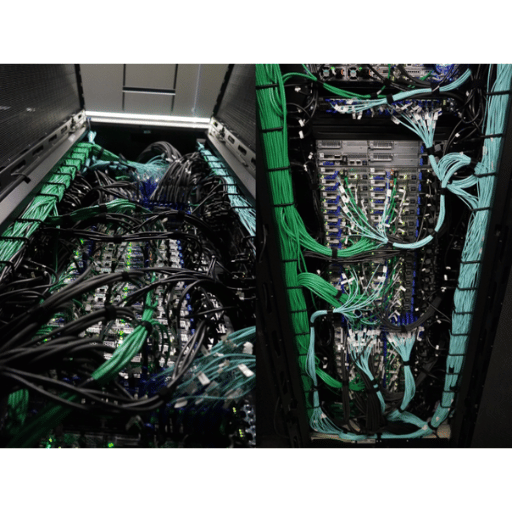

Os cabos e conectores InfiniBand são o backbone da rede, fornecendo transferência de dados em alta velocidade entre dispositivos. Esses cabos vêm em vários comprimentos, de alguns pés a centenas de pés, permitindo configurações de rede flexíveis.

Um dos recursos exclusivos dos cabos e conectores InfiniBand é sua tecnologia de cobre ativo. Essa tecnologia permite que os fios amplifiquem os sinais, melhorando a integridade do sinal e reduzindo a perda de sinal em distâncias maiores.

Os adaptadores InfiniBand são placas de interface de rede (NICs) que permitem que os dispositivos se conectem a redes InfiniBand. Esses adaptadores são projetados para fornecer taxas de transferência de dados de alta velocidade, baixa latência e baixa utilização da CPU.

Os adaptadores InfiniBand vêm em várias configurações, desde adaptadores de porta única até adaptadores de quatro portas. Os adaptadores também suportam diferentes velocidades, variando de 10 Gb/s a 200 Gb/s. Essa flexibilidade permite fácil escalabilidade e design da rede.

Leitura recomendada: Arquitetura de rede de data center – Nuvem-rede integrada Rede de data center – Rede aritmética – Arquitetura SDN

A tecnologia InfiniBand tornou-se uma escolha popular para computação em cluster, que envolve a conexão de vários computadores para trabalharem juntos como um único sistema. A baixa latência e o alto rendimento do InfiniBand o tornam a escolha ideal para aplicativos que requerem processamento de dados em tempo real, como transações financeiras e simulações científicas.

O InfiniBand oferece suporte às tecnologias de análise de mensagens e acesso remoto direto à memória (RDMA), permitindo uma comunicação eficiente entre os nós do cluster. Essa eficiência resulta em maior desempenho e processamento de dados mais rápido.

Construindo redes InfiniBand em Data Centers

Vários elementos-chave são necessários para construir uma rede InfiniBand em um data center, incluindo switches, cabos, conectores e adaptadores. Além disso, é essencial ter uma compreensão completa da topologia e configuração da rede.

Uma das vantagens das redes InfiniBand é seu design modular. Os administradores podem adicionar ou remover switches, cabos e adaptadores sem afetar o desempenho ou a confiabilidade da rede.

Quando se trata de computação de alto desempenho, velocidade e baixa latência são fatores cruciais que podem fazer ou quebrar o sucesso de um aplicativo. Uma tecnologia que revolucionou o mundo da computação de alto desempenho é a InfiniBand, uma arquitetura de rede que permite que os dados sejam transmitidos em velocidades ultrarrápidas.

A InfiniBand Trade Association (IBTA) foi fundada em 1999 para desenvolver e publicar especificações para a tecnologia InfiniBand. O IBTA compreende líderes da indústria de várias empresas, incluindo IBM, Intel, Mellanox Technologies, Oracle, Sepaton e muitas outras. Os principais objetivos do IBTA são estabelecer o InfiniBand como a principal rede para computação de alto desempenho e promover a inovação no campo.

Para atingir esses objetivos, o IBTA estabeleceu uma série de especificações InfiniBand que definem os requisitos de hardware e software InfiniBand. Essas especificações abrangem uma variedade de recursos, incluindo largura de banda, latência, consumo de energia e muito mais. O IBTA atualiza regularmente suas especificações para acompanhar os avanços tecnológicos.

Um dos aspectos fundamentais da tecnologia InfiniBand é sua capacidade de transmitir dados em velocidades incríveis. O IBTA definiu várias especificações InfiniBand que detalham os requisitos máximos de largura de banda e latência para dispositivos InfiniBand. Essas especificações incluem Quadruple Data Rate (QDR), Single Data Rate (SDR) e Double Data Rate (DDR).

QDR é a mais rápida dessas especificações, com uma largura de banda máxima de 40 Gbps (gigabits por segundo) e uma latência de menos de dois microssegundos (μs). O SDR tem uma largura de banda máxima de 10 Gbps e uma latência de menos de cinco μs. O DDR é um avanço do SDR, com uma largura de banda máxima de 20 Gbps e uma latência de menos de três μs.

A especificação InfiniBand mais recente é conhecida como High Data Rate (HDR). Essa especificação foi introduzida em 2017 e se tornou o padrão para computação de alto desempenho. O HDR tem uma largura de banda máxima de 200 Gbps e uma latência de menos de um μs, tornando-o cinco vezes mais rápido que o QDR. O HDR também apresenta um esquema de codificação mais eficiente, reduzindo a sobrecarga da transmissão de dados.

A seguinte especificação InfiniBand é conhecida como Next Data Rate (NDR). Esta especificação está atualmente em desenvolvimento e espera-se que forneça uma largura de banda máxima de 400 Gbps e uma latência inferior a um μs. A NDR usará PAM4 codificação, permitindo distâncias maiores entre dispositivos sem perder a qualidade do sinal.

Então, como o InfiniBand permite computação de baixa latência e alto desempenho? O InfiniBand alcança esses feitos por meio de recursos críticos, incluindo descarregamentos de hardware, acesso remoto direto à memória (RDMA) e controle de congestionamento.

Os descarregamentos de hardware permitem que os adaptadores de rede InfiniBand descarreguem tarefas tradicionalmente executadas pela CPU, como cálculos de soma de verificação e roteamento de mensagens. Esse descarregamento reduz a carga de trabalho da CPU e libera recursos para outras tarefas, melhorando o desempenho geral do sistema.

O RDMA permite que aplicativos em um dispositivo acessem a memória de outro dispositivo diretamente. Esse acesso direto à memória ignora a CPU e a pilha de rede tradicional, reduzindo a latência e melhorando o desempenho geral do sistema. O controle de congestionamento também é crítico no gerenciamento de tráfego em ambientes de computação de alto desempenho. Os mecanismos de controle de congestionamento do InfiniBand evitam o congestionamento da rede e garantem que os dados sejam transmitidos nas velocidades mais altas possíveis.

Leitura recomendada: O que é uma Rede de Data Center? Como gerenciar uma rede de data center

A tecnologia InfiniBand revolucionou a forma como supercomputadores, sistemas de armazenamento, data centers e clusters operam. Seus recursos de transferência de dados em alta velocidade o tornam uma solução essencial em vários setores.

O InfiniBand foi introduzido em 1999 como uma tecnologia de interconexão de alta velocidade para ambientes de computação paralela. É uma tecnologia de baixa latência e alta largura de banda que transfere rapidamente grandes quantidades de dados entre sistemas. A arquitetura InfiniBand usa uma topologia de malha comutada que permite que vários hosts se comuniquem simultânea e independentemente. Ele difere de outras tecnologias concorrentes, como Ethernet e Fibre Channel, devido à sua baixa latência e suporte a alta largura de banda.

InfiniBand é a tecnologia que alimenta os supercomputadores mais rápidos do mundo. Permite alto grau de paralelismo, possibilitando processar grandes quantidades de dados simultaneamente. O InfiniBand desempenha um papel central no projeto de sistemas de computação de alto desempenho (HPC) e é usado em vários tipos de pesquisa científica, como física, biologia e meteorologia. De acordo com o site Top500, que classifica os supercomputadores mais rápidos do mundo, a tecnologia InfiniBand é utilizada em mais de 70% dos sistemas listados entre os 500 melhores.

A tecnologia InfiniBand também é um componente vital em sistemas de armazenamento de alto desempenho. A tecnologia de alta velocidade do InfiniBand permite comunicação rápida de dados entre servidores e sistemas de armazenamento. Baixa latência e alta largura de banda são particularmente úteis para aplicativos com uso intensivo de dados que exigem acesso rápido a grandes quantidades de dados. A tecnologia InfiniBand também pode ajudar a reduzir a latência do sistema de armazenamento em aplicativos de banco de dados, permitindo um processamento mais rápido de consultas e transações.

A tecnologia InfiniBand conecta servidores e outros dispositivos em centros de dados e ambientes de cluster, como sistemas de armazenamento. Os recursos de comunicação de alta velocidade do InfiniBand permitem que os clusters operem como uma única entidade, aprimorando o desempenho de aplicativos que exigem computação paralela. Além disso, o InfiniBand fornece uma interconexão confiável e escalável para plataformas de virtualização, permitindo um uso mais eficiente dos recursos do servidor.

A tecnologia de alta largura de banda e baixa latência do InfiniBand desempenha um papel significativo nas cargas de trabalho de HPC. Ele permite que grandes quantidades de dados sejam processadas simultaneamente, aumentando o desempenho das aplicações de pesquisa científica. O InfiniBand também é usado em modelagem financeira, exploração de petróleo e gás e outras cargas de trabalho com uso intensivo de dados.

A tecnologia InfiniBand continuou a avançar ao longo dos anos, desde seus primeiros dias em ambientes de computação paralela até seu uso generalizado em ambientes de HPC e data center. A mais recente tecnologia InfiniBand fornece velocidades de transferência de dados de até 400 gigabits por segundo (Gbps) por porta, permitindo um processamento de dados mais rápido. As características de baixa latência e alta largura de banda do InfiniBand também são particularmente relevantes em ambientes emergentes de computação quântica. A tecnologia pode permitir uma comunicação mais rápida entre processadores quânticos e computadores clássicos.

As duas empresas líderes no mercado InfiniBand são a Mellanox Technologies (agora parte da NVIDIA) e a Intel Corp. Outras empresas notáveis incluem IBM, Cray, Penguin Computing e Fujitsu. De acordo com o MarketWatch, espera-se que o mercado global de InfiniBand cresça a uma taxa composta de crescimento anual (CAGR) de 18.1% entre 2021 e 2026.

A tecnologia InfiniBand percorreu um longo caminho desde a sua criação no início dos anos 2000. Originalmente projetado como uma interconexão de alta velocidade para clusters de servidor, seus recursos foram expandidos para acomodar as necessidades de uma ampla variedade de aplicativos de computação. Esta seção discutirá as tendências futuras dessa tecnologia e sua crescente importância na computação moderna.

A tecnologia InfiniBand passou por melhorias significativas ao longo dos anos. As versões mais recentes do InfiniBand, incluindo o HDR 200G mais recente, fornecem taxas de transferência de dados ultrarrápidas, baixa latência e desempenho de alta largura de banda. Essas melhorias foram alcançadas por meio da colaboração constante entre as partes interessadas da indústria, órgãos de padronização e comunidades de pesquisa.

Um dos avanços mais significativos na tecnologia InfiniBand é o desenvolvimento de novas interfaces e conectores. Fornecedores como Mellanox e Intel introduziram adaptadores e cabos que facilitam a conexão de dispositivos InfiniBand a sistemas de computação. Um excelente exemplo de uma nova interface é a placa M2PCIE3 apresentada pela Mellanox, que permite aos usuários conectar dispositivos InfiniBand a slots PCIe 3.0.

O InfiniBand é único entre as interconexões de alta velocidade devido à sua baixa latência e recursos de alta largura de banda. Outras tecnologias, como Ethernet e Fibre Channel, não conseguem igualar as taxas de transferência de dados e o desempenho de interconectividade do InfiniBand. O Remote Direct Memory Access (RDMA) do InfiniBand permite que ele mova dados com eficiência sem usar a CPU do host, reduzindo a sobrecarga e permitindo uma transferência de dados mais rápida.

Baixa latência e alta largura de banda são cruciais na computação moderna, especialmente em aplicativos que dependem de análise e processamento de dados em tempo real. A capacidade do InfiniBand de fornecer conectividade de alto desempenho sem comprometer a velocidade ou a latência o torna uma solução popular em clusters de computação de alto desempenho, computação em nuvem e data centers.

A importância da tecnologia InfiniBand na computação moderna provavelmente crescerá nos próximos anos, impulsionada pela crescente necessidade de computação e processamento de dados de alto desempenho. Com o surgimento da Internet das Coisas, análise de big data e inteligência artificial, existe uma demanda crescente por interconectividade de alta largura de banda e baixa latência.

O futuro da tecnologia InfiniBand pode ter mais inovações, como taxas de transferência de dados mais rápidas, menor latência e novos aplicativos em áreas como aprendizado de máquina e direção autônoma. O InfiniBand provavelmente continuará sendo um componente crítico da infraestrutura de computação moderna à medida que a tecnologia evolui.

Leitura recomendada: Data Center e nuvem

R: Infiniband é uma tecnologia de interconexão de alta velocidade usada para transferência de dados em redes de computadores. Ele fornece comunicação de alta largura de banda e baixa latência entre servidores, dispositivos de armazenamento e outros recursos de rede.

R: Infiniband oferece velocidades de transferência de dados mais altas e menor latência do que a Ethernet padrão. É particularmente adequado para a tecnologia RDMA (Remote Direct Memory Access), que permite acesso direto à memória entre máquinas sem envolver a CPU.

R: RDMA significa Remote Direct Memory Access. É uma tecnologia que permite que os dados sejam transferidos diretamente entre a memória de dois computadores sem envolver a CPU. Infiniband suporta RDMA, permitindo transferências de dados rápidas e eficientes.

R: HDR Infiniband (High Data Rate) é a última geração da tecnologia Infiniband que fornece largura de banda ainda maior do que as gerações anteriores. Ele suporta taxas de transferência de dados de até 200 gigabits por segundo.

R: IBTA significa InfiniBand Trade Association. É um consórcio da indústria que desenvolve e promove a tecnologia Infiniband. O consórcio colabora com empresas membros para definir e manter os padrões da indústria para Infiniband.

R: QDR, SDR e DDR são diferentes gerações de tecnologia Infiniband:

R: Infiniband usa o protocolo RDMA para transferência de dados. O RDMA permite que os dados sejam transferidos diretamente entre a memória de duas máquinas sem envolver a CPU, resultando em baixa latência e alto desempenho.

R: ROCE (RDMA over Converged Ethernet) é um protocolo que permite que a tecnologia RDMA seja usada em redes Ethernet padrão. Ele permite comunicação de alta velocidade e baixa latência usando o protocolo Infiniband RDMA em conexões Ethernet.

R: Em Infiniband, um Queue Pair (QP) é uma entidade de comunicação que consiste em uma fila de envio e recebimento. É a unidade básica para transferência e processamento de dados na malha Infiniband.

R: Alguns exemplos de produtos Infiniband incluem adaptadores de canal de host (HCAs), switches, cabos e software. Esses produtos são usados para construir e implantar redes Infiniband.