InfiniBand — это технология высокоскоростной передачи данных, обеспечивающая быструю и эффективную связь между серверами, устройствами хранения и другими вычислительными системами. В отличие от Ethernet, популярной сетевой технологии для локальных сетей (LAN), InfiniBand специально разработан для соединения серверов и кластеров хранения в средах высокопроизводительных вычислений (HPC).

InfiniBand использует двухуровневую архитектуру, которая отделяет физический уровень и уровень канала передачи данных от сетевого уровня. Физический уровень использует последовательные каналы с высокой пропускной способностью, чтобы обеспечить прямое соединение «точка-точка» между устройствами. Канальный уровень, напротив, обрабатывает передачу и прием пакетов данных между устройствами.

Сетевой уровень обеспечивает важнейшие функции InfiniBand, включая виртуализацию, качество обслуживания (QoS) и удаленный прямой доступ к памяти (RDMA). Эти функции делают InfiniBand мощным инструментом для рабочих нагрузок высокопроизводительных вычислений, требующих малой задержки и высокой пропускной способности.

Рекомендуемая литература: EPON, технология доступа Ethernet на большие расстояния, основанная на оптоволоконной транспортной сети.

Одной из важных особенностей InfiniBand является его высокая пропускная способность. InfiniBand может поддерживать скорость передачи данных до 200 гигабит в секунду (Гбит/с), что значительно выше, чем у традиционных сетевых технологий, таких как Ethernet.

InfiniBand также поддерживает QoS, приоритизируя трафик и распределяя ресурсы полосы пропускания по мере необходимости. Это гарантирует, что критические рабочие нагрузки получат необходимую полосу пропускания, а некритические рабочие нагрузки не будут потреблять больше ресурсов, чем им положено.

Еще одной важной особенностью InfiniBand являются возможности виртуализации. InfiniBand поддерживает создание виртуальных дорожек, которые позволяют разделить сеть, чтобы можно было изолировать различные рабочие нагрузки. Это позволяет запускать несколько рабочих нагрузок в одной сети InfiniBand, не мешая друг другу.

Архитектура InfiniBand основана на многоуровневом подходе, который разделяет физический, канальный и сетевой уровни. Физический уровень обеспечивает физическую связь между устройствами, а канальный уровень обрабатывает передачу и прием пакетов данных.

Сетевой уровень обеспечивает важнейшие функции InfiniBand, включая RDMA. RDMA позволяет одному устройству напрямую обращаться к памяти другого устройства без необходимости в промежуточном программном или аппаратном обеспечении. Это устраняет необходимость копирования данных между устройствами, что может значительно уменьшить задержку и повысить производительность.

Архитектура InfiniBand также включает в себя концепцию коммутаторов, которые используются для подключения нескольких устройств. Коммутаторы InfiniBand предназначены для обеспечения связи между устройствами с малой задержкой и высокой пропускной способностью, что делает их идеальными для рабочих нагрузок высокопроизводительных вычислений.

Хотя Ethernet является популярной сетевой технологией для локальных сетей, она не предназначена для удовлетворения требований высокой производительности рабочих нагрузок HPC. Ethernet обычно имеет более высокую задержку и более низкую пропускную способность, чем InfiniBand, что делает его менее подходящим для рабочих нагрузок с интенсивным использованием данных.

Кроме того, Ethernet не поддерживает такие функции, как QoS и RDMA, которые имеют решающее значение для рабочих нагрузок HPC, требующих малой задержки и высокой пропускной способности.

RDMA — это важнейшая функция InfiniBand, которая позволяет устройствам напрямую обращаться к памяти других устройств. С помощью RDMA данные могут передаваться между машинами без промежуточного программного или аппаратного обеспечения, что значительно снижает задержку и повышает производительность.

RDMA в InfiniBand реализуется с использованием двухэтапного процесса. Сначала отправляющее устройство отправляет сообщение принимающему устройству с запросом доступа к его памяти. Затем принимающее устройство предоставляет доступ к своей памяти и возвращает письмо отправителю. Как только доступ предоставлен, отправитель может читать или писать непосредственно в память принимающего устройства.

RDMA особенно полезен для рабочих нагрузок HPC, требующих малой задержки, поскольку устраняет необходимость копирования данных между устройствами, что может привести к дополнительной задержке. RDMA также может снизить загрузку ЦП за счет переноса задач передачи данных на сетевое оборудование, освобождая ресурсы ЦП для других задач.

По мере роста спроса на более высокие скорости передачи данных сетевые системы InfiniBand становятся все более популярными решениями для центров обработки данных. Благодаря высокоскоростным соединениям InfiniBand является отличным выбором для приложений, требующих малой задержки и высокой пропускной способности.

Одним из важнейших элементов сетевой системы InfiniBand являются ее коммутаторы. Коммутаторы InfiniBand отвечают за маршрутизацию данных между устройствами, подключенными к сети. Эти коммутаторы работают на физическом уровне сети, передавая данные с максимально возможной скоростью.

Коммутаторы InfiniBand бывают разных размеров и конфигураций: от небольших кнопок для подключения отдельных серверов до больших коммутаторов для построения высокопроизводительных кластеров. Они также имеют функции качества обслуживания (QoS), которые позволяют администраторам приоритизировать трафик и эффективно управлять сетевыми ресурсами.

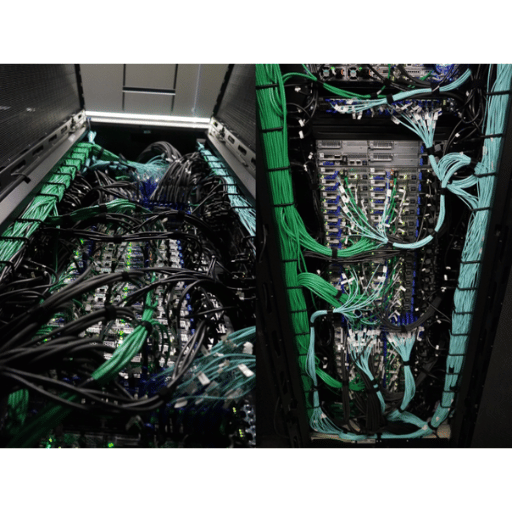

Кабели и разъемы InfiniBand составляют основу сети, обеспечивая высокоскоростную передачу данных между устройствами. Эти кабели бывают различной длины, от нескольких футов до сотен футов, что позволяет создавать гибкие конфигурации сети.

Одной из уникальных особенностей кабелей и разъемов InfiniBand является технология активной меди. Эта технология позволяет проводам усиливать сигналы, улучшая целостность сигнала и уменьшая потери сигнала на больших расстояниях.

Адаптеры InfiniBand — это карты сетевого интерфейса (NIC), которые позволяют устройствам подключаться к сетям InfiniBand. Эти адаптеры предназначены для обеспечения высокой скорости передачи данных, низкой задержки и низкой загрузки ЦП.

Адаптеры InfiniBand поставляются в различных конфигурациях: от однопортовых адаптеров до четырехпортовых адаптеров. Адаптеры также поддерживают различные скорости от 10 Гбит/с до 200 Гбит/с. Такая гибкость позволяет легко масштабировать и проектировать сеть.

Рекомендуемая литература: Архитектура сети центра обработки данных – облачная сеть Интегрированная сеть центра обработки данных – арифметическая сеть – архитектура SDN

Технология InfiniBand стала популярным выбором для кластерных вычислений, которые предполагают подключение нескольких компьютеров для совместной работы в качестве единой системы. Низкая задержка и высокая пропускная способность InfiniBand делают его идеальным выбором для приложений, требующих обработки данных в реальном времени, таких как финансовый трейдинг и научное моделирование.

InfiniBand поддерживает технологии анализа сообщений и удаленного прямого доступа к памяти (RDMA), обеспечивая эффективную связь между узлами кластера. Эта эффективность приводит к более высокой производительности и более быстрой обработке данных.

Построение сетей InfiniBand в центрах обработки данных

Для построения сети InfiniBand в центре обработки данных требуется несколько ключевых элементов, включая коммутаторы, кабели, разъемы и адаптеры. Кроме того, важно иметь полное представление о топологии и конфигурации сети.

Одним из преимуществ сетей InfiniBand является их модульная конструкция. Администраторы могут добавлять или удалять коммутаторы, кабели и адаптеры, не влияя на производительность или надежность сети.

Когда дело доходит до высокопроизводительных вычислений, скорость и низкая задержка являются решающими факторами, которые могут обеспечить или помешать успеху приложения. Одной из технологий, которая произвела революцию в мире высокопроизводительных вычислений, является InfiniBand, сетевая архитектура, которая позволяет передавать данные с молниеносной скоростью.

Торговая ассоциация InfiniBand (IBTA) была основана в 1999 году для разработки и публикации спецификаций для технологии InfiniBand. В состав IBTA входят лидеры отрасли из различных компаний, включая IBM, Intel, Mellanox Technologies, Oracle, Sepaton и многих других. Основные цели IBTA — сделать InfiniBand ведущей сетью для высокопроизводительных вычислений и способствовать инновациям в этой области.

Для достижения этих целей IBTA разработала ряд спецификаций InfiniBand, определяющих требования к аппаратному и программному обеспечению InfiniBand. Эти спецификации охватывают ряд функций, включая пропускную способность, задержку, энергопотребление и многое другое. IBTA регулярно обновляет свои спецификации, чтобы не отставать от технологических достижений.

Одним из фундаментальных аспектов технологии InfiniBand является ее способность передавать данные с невероятной скоростью. IBTA определила несколько спецификаций InfiniBand, в которых подробно описаны требования к максимальной пропускной способности и задержке для устройств InfiniBand. Эти спецификации включают четырехкратную скорость передачи данных (QDR), одинарную скорость передачи данных (SDR) и двойную скорость передачи данных (DDR).

QDR является самой быстрой из этих спецификаций с максимальной пропускной способностью 40 Гбит/с (гигабит в секунду) и задержкой менее двух микросекунд (мкс). SDR имеет максимальную пропускную способность 10 Гбит/с и задержку менее пяти мкс. DDR — это шаг вперед по сравнению с SDR с максимальной пропускной способностью 20 Гбит/с и задержкой менее трех мкс.

Последняя спецификация InfiniBand известна как High Data Rate (HDR). Эта спецификация была представлена в 2017 году и стала стандартом для высокопроизводительных вычислений. HDR имеет максимальную пропускную способность 200 Гбит/с и задержку менее одной мкс, что делает его в пять раз быстрее, чем QDR. HDR также имеет более эффективную схему кодирования, сокращающую накладные расходы на передачу данных.

Следующая спецификация InfiniBand известна как следующая скорость передачи данных (NDR). Эта спецификация в настоящее время находится в стадии разработки и, как ожидается, обеспечит максимальную пропускную способность 400 Гбит/с и задержку менее одной мкс. отчет о недоставке будет использовать PAM4 кодирование, позволяющее увеличить расстояние между устройствами без потери качества сигнала.

Итак, как InfiniBand обеспечивает высокую производительность вычислений с малой задержкой? InfiniBand достигает этих целей благодаря критически важным функциям, включая аппаратную разгрузку, удаленный прямой доступ к памяти (RDMA) и контроль перегрузки.

Аппаратная разгрузка позволяет сетевым адаптерам InfiniBand разгрузить задачи, традиционно выполняемые ЦП, такие как расчет контрольной суммы и маршрутизация сообщений. Такая разгрузка снижает нагрузку на ЦП и высвобождает ресурсы для других задач, повышая общую производительность системы.

RDMA позволяет приложениям на одном устройстве напрямую обращаться к памяти другого устройства. Этот прямой доступ к памяти обходит ЦП и традиционный сетевой стек, уменьшая задержку и повышая общую производительность системы. Контроль перегрузки также имеет решающее значение для управления трафиком в высокопроизводительных вычислительных средах. Механизмы контроля перегрузки InfiniBand предотвращают перегрузку сети и обеспечивают передачу данных на максимально возможных скоростях.

Рекомендуемая литература: Что такое сеть центра обработки данных? Как управлять сетью центра обработки данных

Технология InfiniBand произвела революцию в работе суперкомпьютеров, систем хранения данных, центров обработки данных и кластеров. Его возможности высокоскоростной передачи данных делают его ключевым решением в нескольких отраслях.

InfiniBand был представлен в 1999 году как технология высокоскоростного соединения для параллельных вычислительных сред. Это технология с малой задержкой и высокой пропускной способностью, которая позволяет быстро передавать большие объемы данных между системами. В архитектуре InfiniBand используется топология коммутируемой фабрики, которая позволяет нескольким узлам обмениваться данными одновременно и независимо. Он отличается от других конкурирующих технологий, таких как Ethernet и Fibre Channel, низкой задержкой и поддержкой высокой пропускной способности.

InfiniBand — это технология, на которой работают самые быстрые суперкомпьютеры в мире. Он обеспечивает высокую степень параллелизма, что позволяет одновременно обрабатывать большие объемы данных. InfiniBand играет центральную роль в разработке систем высокопроизводительных вычислений (HPC) и используется в различных типах научных исследований, таких как физика, биология и метеорология. Согласно веб-сайту Top500, который оценивает самые быстрые суперкомпьютеры в мире, технология InfiniBand используется более чем в 70% систем, перечисленных в топ-500.

Технология InfiniBand также является жизненно важным компонентом высокопроизводительных систем хранения данных. Высокоскоростная технология InfiniBand обеспечивает быструю передачу данных между серверами и системами хранения. Низкая задержка и высокая пропускная способность особенно полезны для приложений, интенсивно использующих данные, которым требуется быстрый доступ к большим объемам данных. Технология InfiniBand также помогает уменьшить задержку системы хранения в приложениях баз данных, обеспечивая более быструю обработку запросов и транзакций.

Технология InfiniBand соединяет серверы и другие устройства в центрах обработки данных и кластерных средах, таких как системы хранения. Возможности высокоскоростной связи InfiniBand позволяют кластерам работать как единое целое, повышая производительность приложений, требующих параллельных вычислений. Кроме того, InfiniBand обеспечивает надежное и масштабируемое соединение для платформ виртуализации, позволяя более эффективно использовать ресурсы сервера.

Технология InfiniBand с высокой пропускной способностью и малой задержкой играет важную роль в рабочих нагрузках HPC. Это позволяет одновременно обрабатывать большие объемы данных, повышая производительность приложений для научных исследований. InfiniBand также используется в финансовом моделировании, разведке нефти и газа и других рабочих нагрузках, требующих большого объема данных.

Технология InfiniBand продолжала развиваться на протяжении многих лет, начиная с ее первых дней в параллельных вычислительных средах и заканчивая ее широким использованием в средах высокопроизводительных вычислений и центров обработки данных. Новейшая технология InfiniBand обеспечивает скорость передачи данных до 400 гигабит в секунду (Гбит/с) на порт, что позволяет ускорить обработку данных. Характеристики InfiniBand с низкой задержкой и высокой пропускной способностью также особенно актуальны в новых средах квантовых вычислений. Эта технология может обеспечить более быструю связь между квантовыми процессорами и классическими компьютерами.

Двумя ведущими игроками на рынке InfiniBand являются Mellanox Technologies (теперь часть NVIDIA) и Intel Corp. Другие известные компании включают IBM, Cray, Penguin Computing и Fujitsu. По данным MarketWatch, ожидается, что мировой рынок InfiniBand будет расти со среднегодовым темпом роста (CAGR) 18.1% в период с 2021 по 2026 год.

Технология InfiniBand прошла долгий путь с момента своего появления в начале 2000-х годов. Первоначально разработанный как высокоскоростное межсоединение для кластеров серверов, его возможности расширились, чтобы удовлетворить потребности широкого спектра вычислительных приложений. В этом разделе будут обсуждаться будущие тенденции этой технологии и ее растущее значение в современных вычислениях.

За прошедшие годы технология InfiniBand претерпела значительные улучшения. Последние версии InfiniBand, в том числе самая последняя версия HDR 200G, обеспечивают сверхвысокую скорость передачи данных, малую задержку и высокую пропускную способность. Эти улучшения были достигнуты благодаря постоянному сотрудничеству между заинтересованными сторонами отрасли, органами по стандартизации и исследовательскими сообществами.

Одним из наиболее значительных достижений в технологии InfiniBand является разработка новых интерфейсов и разъемов. Такие поставщики, как Mellanox и Intel, представили адаптеры и кабели, упрощающие подключение устройств InfiniBand к вычислительным системам. Прекрасным примером нового интерфейса является карта M2PCIE3, представленная Mellanox, которая позволяет пользователям подключать устройства InfiniBand к слотам PCIe 3.0.

InfiniBand уникален среди высокоскоростных межсоединений благодаря низкой задержке и высокой пропускной способности. Другие технологии, такие как Ethernet и Fibre Channel, не могут сравниться со скоростью передачи данных InfiniBand и производительностью межсетевого взаимодействия. Удаленный прямой доступ к памяти (RDMA) InfiniBand позволяет эффективно перемещать данные без использования центрального процессора, снижая накладные расходы и обеспечивая более быструю передачу данных.

Низкая задержка и высокая пропускная способность имеют решающее значение в современных вычислениях, особенно в приложениях, которые полагаются на обработку и аналитику данных в реальном времени. Способность InfiniBand обеспечивать высокопроизводительное подключение без ущерба для скорости или задержки делает его популярным решением в высокопроизводительных вычислительных кластерах, облачных вычислениях и центрах обработки данных.

Значение технологии InfiniBand в современных вычислениях, вероятно, возрастет в ближайшие годы из-за растущей потребности в высокопроизводительных вычислениях и обработке данных. С появлением Интернета вещей, аналитики больших данных и искусственного интеллекта существует растущий спрос на межсетевое взаимодействие с высокой пропускной способностью и малой задержкой.

В будущем технология InfiniBand может увидеть больше инноваций, таких как более высокая скорость передачи данных, меньшая задержка и новые приложения в таких областях, как машинное обучение и автономное вождение. InfiniBand, скорее всего, останется важнейшим компонентом современной вычислительной инфраструктуры по мере развития технологии.

Рекомендуемая литература: Дата-центр и облако

О: Infiniband — это технология высокоскоростного соединения, используемая для передачи данных в компьютерных сетях. Он обеспечивает высокую пропускную способность и низкую задержку связи между серверами, устройствами хранения и другими сетевыми ресурсами.

A: Infiniband предлагает более высокую скорость передачи данных и меньшую задержку, чем стандартный Ethernet. Он особенно хорошо подходит для технологии RDMA (удаленный прямой доступ к памяти), которая обеспечивает прямой доступ к памяти между машинами без участия ЦП.

О: RDMA означает удаленный прямой доступ к памяти. Это технология, которая позволяет передавать данные напрямую между памятью двух компьютеров без участия центрального процессора. Infiniband поддерживает RDMA, обеспечивая быструю и эффективную передачу данных.

О: HDR Infiniband (высокая скорость передачи данных) — это технология Infiniband последнего поколения, которая обеспечивает еще более высокую пропускную способность, чем предыдущие поколения. Он поддерживает скорость передачи данных до 200 гигабит в секунду.

О: IBTA расшифровывается как Торговая ассоциация InfiniBand. Это отраслевой консорциум, который разрабатывает и продвигает технологию Infiniband. Консорциум сотрудничает с компаниями-членами для определения и поддержания отраслевых стандартов для Infiniband.

О: QDR, SDR и DDR — это разные поколения технологии Infiniband:

A: Infiniband использует протокол RDMA для передачи данных. RDMA позволяет передавать данные напрямую между памятью двух машин, не задействуя центральный процессор, что приводит к низкой задержке и высокой производительности.

О: ROCE (RDMA через конвергентный Ethernet) — это протокол, который позволяет использовать технологию RDMA в стандартных сетях Ethernet. Он обеспечивает высокоскоростную связь с малой задержкой с использованием протокола Infiniband RDMA через соединения Ethernet.

A: В Infiniband пара очереди (QP) — это коммуникационный объект, состоящий из очереди отправки и получения. Это основной модуль для передачи и обработки данных в фабрике Infiniband.

О: Некоторые примеры продуктов Infiniband включают адаптеры хост-канала (HCA), коммутаторы, кабели и программное обеспечение. Эти продукты используются для создания и развертывания сетей Infiniband.