InfiniBand は、サーバー、ストレージ デバイス、およびその他のコンピューティング システム間の高速かつ効率的な通信を可能にする高速データ転送テクノロジです。 ローカル エリア ネットワーク (LAN) の一般的なネットワーキング テクノロジであるイーサネットとは異なり、InfiniBand は、ハイ パフォーマンス コンピューティング (HPC) 環境でサーバーとストレージ クラスターを接続するように明示的に設計されています。

InfiniBand は、物理層とデータリンク層をネットワーク層から分離する XNUMX 層アーキテクチャを使用します。 物理層は高帯域幅のシリアル リンクを使用して、デバイス間の直接のポイントツーポイント接続を提供します。 対照的に、データリンク層はデバイス間のデータパケットの送受信を処理します。

ネットワーク層は、仮想化、サービス品質 (QoS)、リモート ダイレクト メモリ アクセス (RDMA) などの InfiniBand の重要な機能を提供します。 これらの機能により、InfiniBand は、低遅延と高帯域幅を必要とする HPC ワークロードにとって強力なツールになります。

推奨書籍: EPON、光ファイバートランスポートネットワークに基づく長距離イーサネットアクセステクノロジー

InfiniBand の重要な機能の 200 つは、その高帯域幅です。 InfiniBand は、最大 XNUMX ギガビット/秒 (Gbps) のデータ転送速度をサポートでき、イーサネットなどの従来のネットワーク テクノロジよりも大幅に高速です。

InfiniBand は QoS もサポートしており、必要に応じてトラフィックに優先順位を付け、帯域幅リソースを割り当てます。 これにより、重要なワークロードが必要な帯域幅を受け取り、重要でないワークロードがリソースの公平なシェアを超えて消費しないことが保証されます。

InfiniBand のもう XNUMX つの重要な機能は、仮想化機能です。 InfiniBand は、さまざまなワークロードを分離できるようにネットワークを分割する方法を提供する仮想レーンの作成をサポートしています。 これにより、複数のワークロードが互いに干渉することなく、同じ InfiniBand ネットワーク上で実行できるようになります。

InfiniBand アーキテクチャは、物理層、データ リンク層、ネットワーク層を分離する階層化アプローチに基づいています。 物理層はデバイス間の物理接続を提供し、データリンク層はデータ パケットの送受信を処理します。

ネットワーク層は、RDMA などの InfiniBand の重要な機能を提供します。 RDMA は、中間のソフトウェアやハードウェアを必要とせずに、あるデバイスが別のデバイスのメモリに直接アクセスする方法を提供します。 これにより、デバイス間でデータをコピーする必要がなくなり、待ち時間が大幅に短縮され、パフォーマンスが向上します。

InfiniBand アーキテクチャには、複数のデバイスの接続に使用されるスイッチの概念も含まれています。 InfiniBand スイッチは、デバイス間に低遅延、高帯域幅の接続を提供するように設計されており、HPC ワークロードに最適です。

イーサネットは LAN 用の一般的なネットワーク テクノロジですが、HPC ワークロードの高性能要件向けに設計されていません。 イーサネットは通常、InfiniBand よりも遅延が長く、帯域幅が狭いため、データ集約型のワークロードにはあまり適していません。

さらに、イーサネットは、低遅延と高帯域幅を必要とする HPC ワークロードにとって重要な QoS や RDMA などの機能をサポートしていません。

RDMA は、デバイスが他のデバイスのメモリに直接アクセスする方法を提供する InfiniBand の重要な機能です。 RDMA を使用すると、中間のソフトウェアやハードウェアを使用せずにマシン間でデータを転送できるため、待ち時間が大幅に短縮され、パフォーマンスが向上します。

InfiniBand の RDMA は XNUMX 段階のプロセスを使用して実装されます。 まず、送信デバイスは受信デバイスにメモリへのアクセスを要求するメッセージを送信します。 次に、受信デバイスはメモリへのアクセスを許可し、送信者に手紙を返します。 アクセスが許可されると、送信者は受信デバイスのメモリを直接読み書きできるようになります。

RDMA は、追加の遅延を引き起こす可能性があるデバイス間でのデータのコピーの必要性を排除するため、低遅延を必要とする HPC ワークロードに特に役立ちます。 RDMA は、データ転送タスクをネットワーク ハードウェアにオフロードし、CPU リソースを他のジョブに解放することで CPU 使用率を削減することもできます。

より高速なデータ転送速度に対する需要が高まるにつれ、InfiniBand ネットワーク システムはデータセンター向けのソリューションとしてますます人気が高まっています。 高速接続を備えた InfiniBand は、低遅延と高スループットを必要とするアプリケーションに最適です。

InfiniBand ネットワーク システムの重要な要素の XNUMX つはスイッチです。 InfiniBand スイッチは、ネットワークに接続されたデバイス間のデータのルーティングを担当します。 これらのスイッチはネットワークの物理層で動作し、可能な限り最高の速度でデータを送信します。

InfiniBand スイッチには、個々のサーバーを接続するための小さなボタンから、高性能クラスターを構築するための大きなスイッチまで、さまざまなサイズと構成があります。 また、Quality of Service (QoS) 機能も備えているため、管理者はトラフィックに優先順位を付け、ネットワーク リソースを効果的に管理できます。

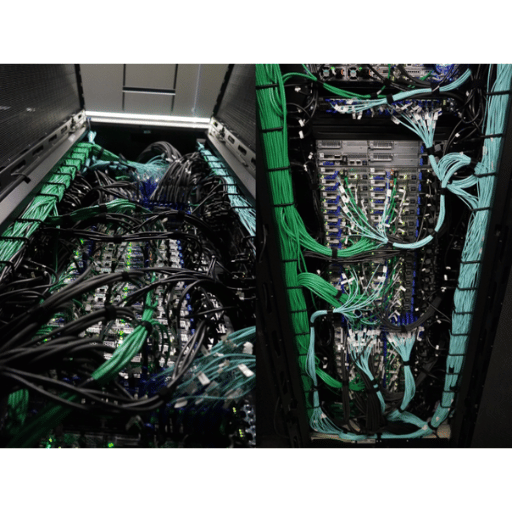

InfiniBand ケーブルとコネクタはネットワークのバックボーンであり、デバイス間の高速データ転送を実現します。 これらのケーブルには、数フィートから数百フィートまでさまざまな長さがあり、柔軟なネットワーク構成が可能です。

InfiniBand ケーブルとコネクタのユニークな機能の XNUMX つは、アクティブ銅テクノロジーです。 この技術により、ワイヤが信号を増幅し、信号の完全性が向上し、長距離にわたる信号損失が軽減されます。

InfiniBand アダプターは、デバイスが InfiniBand ネットワークに接続できるようにするネットワーク インターフェイス カード (NIC) です。 これらのアダプターは、高速データ転送速度、低遅延、低 CPU 使用率を実現するように設計されています。

InfiniBand アダプタには、シングル ポート アダプタからクアッド ポート アダプタまで、さまざまな構成があります。 アダプターは、10Gb/s から 200Gb/s までのさまざまな速度もサポートします。 この柔軟性により、ネットワークの拡張性と設計が容易になります。

推奨書籍: データセンター ネットワーク アーキテクチャ – クラウド ネットワーク 統合データセンター ネットワーク – 算術ネットワーク – SDN アーキテクチャ

InfiniBand テクノロジは、複数のコンピュータを接続して単一のシステムとして動作させるクラスタ コンピューティングの一般的な選択肢となっています。 InfiniBand は低レイテンシーと高スループットを備えているため、金融取引や科学シミュレーションなど、リアルタイムのデータ処理を必要とするアプリケーションにとって理想的な選択肢となります。

InfiniBand は、メッセージ解析およびリモート ダイレクト メモリ アクセス (RDMA) テクノロジをサポートしており、クラスタ ノード間の効率的な通信を可能にします。 この効率により、パフォーマンスが向上し、データ処理が高速になります。

データセンターでの InfiniBand ネットワークの構築

データセンターに InfiniBand ネットワークを構築するには、スイッチ、ケーブル、コネクタ、アダプタなど、いくつかの重要な要素が必要です。 さらに、ネットワーク トポロジと構成を完全に理解することが不可欠です。

InfiniBand ネットワークの利点の XNUMX つは、そのモジュラー設計です。 管理者は、ネットワークのパフォーマンスや信頼性に影響を与えることなく、スイッチ、ケーブル、アダプターを追加または削除できます。

ハイ パフォーマンス コンピューティングに関しては、速度と低遅延がアプリケーションの成功を左右する重要な要素です。 ハイパフォーマンス コンピューティングの世界に革命をもたらしたテクノロジーの XNUMX つが、超高速でのデータ送信を可能にするネットワーク アーキテクチャである InfiniBand です。

InfiniBand Trade Association (IBTA) は、InfiniBand テクノロジの仕様を開発および公開するために 1999 年に設立されました。 IBTA は、IBM、Intel、Mellanox Technologies、Oracle、Sepaton など、さまざまな企業の業界リーダーで構成されています。 IBTA の主な目標は、InfiniBand をハイパフォーマンス コンピューティングのプレミア ネットワークとして確立し、この分野のイノベーションを促進することです。

これらの目標を達成するために、IBTA は、InfiniBand ハードウェアおよびソフトウェアの要件を定義する一連の InfiniBand 仕様を確立しました。 これらの仕様は、帯域幅、遅延、消費電力などを含むさまざまな機能をカバーしています。 IBTA は、技術の進歩に対応するために仕様を定期的に更新します。

InfiniBand テクノロジーの基本的な側面の XNUMX つは、驚異的な速度でデータを送信できることです。 IBTA は、InfiniBand デバイスの最大帯域幅と遅延要件を詳細に説明するいくつかの InfiniBand 仕様を定義しています。 これらの仕様には、クアッド データ レート (QDR)、シングル データ レート (SDR)、およびダブル データ レート (DDR) が含まれます。

QDR はこれらの仕様の中で最も高速で、最大帯域幅は 40 Gbps (ギガビット/秒)、遅延は 10 マイクロ秒 (μs) 未満です。 SDR の最大帯域幅は 20 Gbps、遅延は XNUMX μs 未満です。 DDR は SDR から一歩進んだもので、最大帯域幅は XNUMX Gbps、遅延は XNUMX μs 未満です。

最新の InfiniBand 仕様は、高データ レート (HDR) として知られています。 この仕様は 2017 年に導入され、ハイ パフォーマンス コンピューティングの標準となっています。 HDR の最大帯域幅は 200 Gbps、遅延は XNUMX μs 未満で、QDR よりも XNUMX 倍高速です。 HDR は、より効率的なエンコード方式も備えており、データ送信のオーバーヘッドを削減します。

次の InfiniBand 仕様は、Next Data Rate (NDR) として知られています。 この仕様は現在開発中で、最大 400 Gbps の帯域幅と XNUMX μs 未満の遅延を実現すると予想されています。 NDR が使用する PAM4 エンコーディングにより、信号品質を損なうことなくデバイス間の距離を長くすることができます。

では、InfiniBand はどのようにして低遅延で高性能のコンピューティングを可能にするのでしょうか? InfiniBand は、ハードウェア オフロード、リモート ダイレクト メモリ アクセス (RDMA)、輻輳制御などの重要な機能を通じてこれらの機能を実現します。

ハードウェア オフロードにより、InfiniBand ネットワーク アダプタは、チェックサム計算やメッセージ ルーティングなど、従来 CPU によって実行されていたタスクをオフロードできます。 このオフロードにより、CPU のワークロードが軽減され、リソースが他のジョブに解放され、システム全体のパフォーマンスが向上します。

RDMA を使用すると、あるデバイス上のアプリケーションが別のデバイスのメモリに直接アクセスできるようになります。 このダイレクト メモリ アクセスにより、CPU と従来のネットワーク スタックがバイパスされ、レイテンシが短縮され、システム全体のパフォーマンスが向上します。 輻輳制御は、ハイパフォーマンス コンピューティング環境のトラフィックを管理する場合にも重要です。 InfiniBand の輻輳制御メカニズムは、ネットワークの輻輳を防止し、可能な限り最高の速度でデータが送信されることを保証します。

推奨書籍: データセンターネットワークとは何ですか? データセンターネットワークを管理する方法

InfiniBand テクノロジーは、スーパーコンピューター、ストレージ システム、データ センター、クラスターの運用方法に革命をもたらしました。 高速データ転送機能により、いくつかの業界で重要なソリューションとなっています。

InfiniBand は、並列コンピューティング環境用の高速相互接続テクノロジとして 1999 年に導入されました。 これは、システム間で大量のデータを迅速に転送する、低遅延、高帯域幅のテクノロジです。 InfiniBand アーキテクチャは、複数のホストが同時に独立して通信できるようにするスイッチ ファブリック トポロジを使用します。 低遅延と高帯域幅のサポートにより、イーサネットやファイバー チャネルなどの他の競合テクノロジーとは異なります。

InfiniBand は、世界最速のスーパーコンピューターを駆動するテクノロジーです。 高度な並列処理が可能になり、大量のデータを同時に処理できるようになります。 InfiniBand は、ハイ パフォーマンス コンピューティング (HPC) システムの設計で中心的な役割を果たし、物理学、生物学、気象学などのさまざまなタイプの科学研究で使用されています。 世界最速のスーパーコンピューターをランキングする Top500 Web サイトによると、InfiniBand テクノロジーはトップ 70 にリストされているシステムの 500% 以上で使用されています。

InfiniBand テクノロジーは、高性能ストレージ システムの重要なコンポーネントでもあります。 InfiniBand の高速テクノロジーにより、サーバーとストレージ システム間の高速データ通信が可能になります。 低遅延と高帯域幅は、大量のデータに迅速にアクセスする必要があるデータ集約型アプリケーションに特に役立ちます。 InfiniBand テクノロジは、データベース アプリケーションにおけるストレージ システムの遅延の削減にも役立ち、クエリやトランザクションのより迅速な処理が可能になります。

InfiniBand テクノロジーは、データセンターおよびストレージ システムなどのクラスター環境内のサーバーとその他のデバイスを接続します。 InfiniBand の高速通信機能により、クラスターが単一エンティティとして動作できるようになり、並列コンピューティングを必要とするアプリケーションのパフォーマンスが向上します。 さらに、InfiniBand は仮想化プラットフォームに信頼性が高くスケーラブルな相互接続を提供し、サーバー リソースのより効率的な使用を可能にします。

InfiniBand の高帯域幅および低遅延テクノロジーは、HPC ワークロードにおいて重要な役割を果たします。 大量のデータを同時に処理できるようになり、科学研究アプリケーションのパフォーマンスが向上します。 InfiniBand は、財務モデリング、石油とガスの探査、その他のデータ集約型のワークロードでも使用されます。

InfiniBand テクノロジは、並列コンピューティング環境における初期の段階から、HPC およびデータセンター環境での広範な使用に至るまで、長年にわたって進歩し続けてきました。 最新の InfiniBand テクノロジーは、ポートあたり最大 400 ギガビット/秒 (Gbps) のデータ転送速度を提供し、より高速なデータ処理を可能にします。 InfiniBand の低レイテンシと高帯域幅の特性は、新興の量子コンピューティング環境にも特に関係します。 この技術により、量子プロセッサと古典的なコンピュータ間の通信が高速化されます。

InfiniBand 市場の 18.1 つの主要企業は、Mellanox Technologies (現在は NVIDIA の一部) と Intel Corp. です。その他の著名な企業には、IBM、Cray、Penguin Computing、富士通などがあります。 MarketWatch によると、世界の InfiniBand 市場は、2021 年から 2026 年の間に XNUMX% の年間複合成長率 (CAGR) で成長すると予想されています。

InfiniBand テクノロジーは、2000 年代初頭の登場以来、長い進歩を遂げてきました。 元々はサーバー クラスター用の高速インターコネクトとして設計されましたが、その機能は幅広いコンピューティング アプリケーションのニーズに対応するために拡張されました。 このセクションでは、このテクノロジーの将来の傾向と、現代のコンピューティングにおけるその重要性の増大について説明します。

InfiniBand テクノロジーは、長年にわたって大幅な改良が加えられてきました。 最新の HDR 200G を含む InfiniBand の最新バージョンは、超高速のデータ転送速度、低遅延、高帯域幅のパフォーマンスを提供します。 これらの改善は、業界関係者、標準化団体、研究コミュニティ間の継続的な協力によって達成されました。

InfiniBand テクノロジーの最も重要な進歩の 2 つは、新しいインターフェイスとコネクタの開発です。 Mellanox や Intel などのベンダーは、InfiniBand デバイスをコンピューティング システムに簡単に接続できるようにするアダプターやケーブルを導入しました。 新しいインターフェイスの優れた例は、Mellanox が提供する M3PCIE3.0 カードです。これを使用すると、ユーザーは InfiniBand デバイスを PCIe XNUMX スロットに接続できます。

InfiniBand は、その低遅延と高帯域幅機能により、高速相互接続の中でも独特です。 イーサネットやファイバー チャネルなどの他のテクノロジーは、InfiniBand のデータ転送速度と相互接続パフォーマンスに匹敵することはできません。 InfiniBand のリモート ダイレクト メモリ アクセス (RDMA) により、ホスト CPU を使用せずにデータを効率的に移動できるため、オーバーヘッドが削減され、より高速なデータ転送が可能になります。

最新のコンピューティング、特にリアルタイムのデータ処理と分析に依存するアプリケーションでは、低遅延と高帯域幅が非常に重要です。 InfiniBand は、速度や遅延を犠牲にすることなく高性能の接続を提供できるため、高性能コンピューティング クラスター、クラウド コンピューティング、データ センターで人気のソリューションとなっています。

高性能コンピューティングとデータ処理のニーズの高まりにより、現代のコンピューティングにおける InfiniBand テクノロジーの重要性は今後数年間でさらに高まると考えられます。 モノのインターネット、ビッグデータ分析、人工知能の台頭により、高帯域幅と低遅延の相互接続に対する需要が高まっています。

InfiniBand テクノロジーの将来では、データ転送速度の高速化、遅延の短縮、機械学習や自動運転などの分野での新しいアプリケーションなど、さらなるイノベーションが起こる可能性があります。 InfiniBand は、テクノロジーが進化しても、現代のコンピューティング インフラストラクチャの重要なコンポーネントであり続けるでしょう。

推奨書籍: データセンターとクラウド

A: Infiniband は、コンピュータ ネットワークにおけるデータ転送に使用される高速相互接続テクノロジです。 サーバー、ストレージ デバイス、その他のネットワーク リソース間の高帯域幅と低遅延の通信を提供します。

A: Infiniband は、標準のイーサネットよりも高いデータ転送速度と低い遅延を提供します。 これは、CPU を介さずにマシン間の直接メモリ アクセスを可能にする RDMA (リモート ダイレクト メモリ アクセス) テクノロジに特に適しています。

A: RDMA はリモート ダイレクト メモリ アクセスの略です。 CPUを介さずにXNUMX台のコンピュータのメモリ間で直接データを転送できる技術です。 Infiniband は RDMA をサポートし、高速かつ効率的なデータ転送を可能にします。

A: HDR Infiniband (高データ レート) は、前世代よりもさらに高い帯域幅を提供する最新世代の Infiniband テクノロジーです。 最大 200 ギガビット/秒のデータ転送速度をサポートします。

A: IBTA は InfiniBand Trade Association の略です。 これは、Infiniband テクノロジーを開発および推進する業界コンソーシアムです。 コンソーシアムはメンバー企業と協力して、Infiniband の業界標準を定義および維持しています。

A: QDR、SDR、および DDR は、異なる世代の Infiniband テクノロジーです。

A: Infiniband はデータ転送に RDMA プロトコルを使用します。 RDMA を使用すると、CPU を介さずに XNUMX 台のマシンのメモリ間でデータを直接転送できるため、待ち時間が短くなり、パフォーマンスが向上します。

A: ROCE (RDMA over Converged Ethernet) は、標準のイーサネット ネットワーク上で RDMA テクノロジーを使用できるようにするプロトコルです。 これにより、イーサネット接続上で Infiniband RDMA プロトコルを使用した高速かつ低遅延の通信が可能になります。

A: Infiniband では、キュー ペア (QP) は送信キューと受信キューで構成される通信エンティティです。 これは、Infiniband ファブリックでのデータ転送と処理の基本単位です。

A: Infiniband 製品の例には、ホスト チャネル アダプタ (HCA)、スイッチ、ケーブル、ソフトウェアなどがあります。 これらの製品は、Infiniband ネットワークの構築と展開に使用されます。