InfiniBand 是一种高速数据传输技术,可实现服务器、存储设备和其他计算系统之间快速高效的通信。 与以太网(一种流行的局域网 (LAN) 网络技术)不同,InfiniBand 专门设计用于连接高性能计算 (HPC) 环境中的服务器和存储集群。

InfiniBand 采用两层架构,将物理层和数据链路层与网络层分开。 物理层使用高带宽串行链路在设备之间提供直接的点对点连接。 相反,数据链路层处理设备之间数据包的传输和接收。

网络层提供 InfiniBand 的关键功能,包括虚拟化、服务质量 (QoS) 和远程直接内存访问 (RDMA)。 这些功能使 InfiniBand 成为需要低延迟和高带宽的 HPC 工作负载的强大工具。

推荐阅读: EPON,一种基于光纤传送网的长距离以太网接入技术

InfiniBand 的关键特性之一是其高带宽。 InfiniBand 可支持高达 200 Gbps 的数据传输速率,比以太网等传统网络技术快得多。

InfiniBand 还支持 QoS、确定流量优先级并根据需要分配带宽资源。 这可确保关键工作负载获得必要的带宽,并且非关键工作负载消耗的资源不会超过其公平份额。

InfiniBand 的另一个重要特性是其虚拟化功能。 InfiniBand 支持创建虚拟通道,这提供了一种划分网络的方法,以便隔离不同的工作负载。 这使得多个工作负载可以在同一个 InfiniBand 网络上运行,而不会相互干扰。

InfiniBand 架构基于分层方法,将物理层、数据链路层和网络层分开。 物理层提供设备之间的物理连接,而数据链路层处理数据包的发送和接收。

网络层提供 InfiniBand 的关键功能,包括 RDMA。 RDMA 为一个设备提供了一种直接访问另一个设备内存的方法,无需中间软件或硬件。 这样就无需在设备之间复制数据,从而可以显着减少延迟并提高性能。

InfiniBand架构还包括交换机的概念,用于连接多个设备。 InfiniBand 交换机旨在在设备之间提供低延迟、高带宽连接,使其成为 HPC 工作负载的理想选择。

虽然以太网是一种流行的 LAN 网络技术,但它并不是为 HPC 工作负载的高性能要求而设计的。 以太网通常比 InfiniBand 具有更高的延迟和更低的带宽,使其不太适合数据密集型工作负载。

此外,以太网不支持 QoS 和 RDMA 等功能,而这些功能对于需要低延迟和高带宽的 HPC 工作负载至关重要。

RDMA 是 InfiniBand 的一项重要功能,它为设备提供了一种直接访问其他设备内存的方式。 通过 RDMA,数据可以在机器之间传输,无需中间软件或硬件,从而显着减少延迟并提高性能。

InfiniBand 中的 RDMA 是通过两步过程实现的。 首先,发送设备向接收设备发送消息,请求访问其存储器。 然后,接收设备授予对其内存的访问权限,并向发送者返回一封信。 一旦获得访问权限,发送方就可以直接读取或写入接收设备的内存。

RDMA 对于需要低延迟的 HPC 工作负载特别有用,因为它消除了在设备之间复制数据的需要,这可能会带来额外的延迟。 RDMA 还可以通过将数据传输任务卸载到网络硬件来降低 CPU 利用率,从而为其他作业释放 CPU 资源。

随着对更快数据传输速度的需求不断增长,InfiniBand 网络系统已成为数据中心日益流行的解决方案。 凭借其高速连接,InfiniBand 是需要低延迟和高吞吐量的应用程序的绝佳选择。

InfiniBand 网络系统的关键要素之一是其交换机。 InfiniBand 交换机负责在连接到网络的设备之间路由数据。 这些交换机工作在网络的物理层,以尽可能高的速度传输数据。

InfiniBand 交换机有各种尺寸和配置,从用于连接单个服务器的小按钮到用于构建高性能集群的大型交换机。 它们还具有服务质量 (QoS) 功能,使管理员能够确定流量的优先级并有效地管理网络资源。

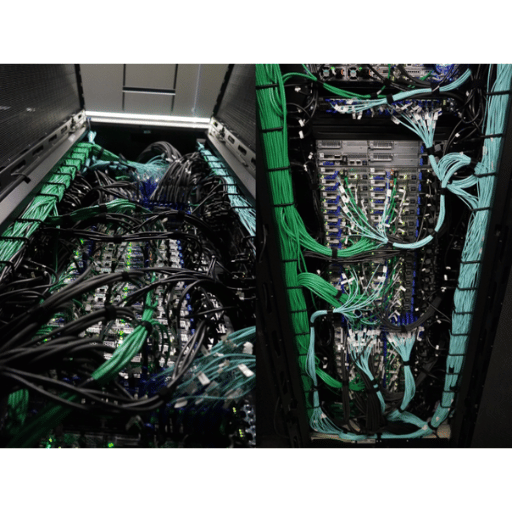

InfiniBand 电缆和连接器是网络的主干,可在设备之间提供高速数据传输。 这些电缆有多种长度,从几英尺到数百英尺不等,可实现灵活的网络配置。

InfiniBand 电缆和连接器的独特功能之一是其有源铜技术。 该技术允许电线放大信号,提高信号完整性并减少较长距离的信号损失。

InfiniBand 适配器是网络接口卡 (NIC),使设备能够连接到 InfiniBand 网络。 这些适配器旨在提供高速数据传输速率、低延迟和低 CPU 利用率。

InfiniBand 适配器有多种配置,从单端口适配器到四端口适配器。 这些适配器还支持不同的速度,范围从 10Gb/s 到 200Gb/s。 这种灵活性可以轻松实现网络的可扩展性和设计。

推荐阅读: 数据中心网络架构-云网融合数据中心网络-算术网络-SDN架构

InfiniBand 技术已成为集群计算的流行选择,集群计算涉及连接多台计算机作为单个系统协同工作。 InfiniBand 的低延迟和高吞吐量使其成为需要实时数据处理的应用程序(例如金融交易和科学模拟)的理想选择。

InfiniBand 支持消息解析和远程直接内存访问 (RDMA) 技术,允许集群节点之间进行高效通信。 这种效率可带来更高的性能和更快的数据处理速度。

在数据中心构建 InfiniBand 网络

在数据中心构建 InfiniBand 网络需要几个关键元素,包括交换机、电缆、连接器和适配器。 此外,必须彻底了解网络拓扑和配置。

InfiniBand 网络的优势之一是其模块化设计。 管理员可以添加或删除交换机、电缆和适配器,而不会影响网络的性能或可靠性。

当谈到高性能计算时,速度和低延迟是决定应用程序成功或失败的关键因素。 InfiniBand 是一项彻底改变高性能计算世界的技术,它是一种能够以闪电般的速度传输数据的网络架构。

InfiniBand 贸易协会 (IBTA) 成立于 1999 年,旨在开发和发布 InfiniBand 技术规范。 IBTA 由来自不同公司的行业领导者组成,包括 IBM、Intel、Mellanox Technologies、Oracle、Sepaton 等。 IBTA 的主要目标是将 InfiniBand 打造为高性能计算的首要网络并促进该领域的创新。

为了实现这些目标,IBTA 制定了一系列 InfiniBand 规范,定义了 InfiniBand 硬件和软件的要求。 这些规范涵盖了一系列功能,包括带宽、延迟、功耗等。 IBTA 定期更新其规范,以跟上技术进步。

InfiniBand 技术的基本特点之一是能够以令人难以置信的速度传输数据。 IBTA 定义了多个 InfiniBand 规范,详细说明了 InfiniBand 设备的最大带宽和延迟要求。 这些规格包括四倍数据速率 (QDR)、单倍数据速率 (SDR) 和双倍数据速率 (DDR)。

QDR 是这些规范中速度最快的,最大带宽为 40 Gbps(千兆位每秒),延迟小于两微秒 (μs)。 SDR的最大带宽为10Gbps,时延小于20μs。 DDR 是 SDR 的升级版,最大带宽为 XNUMX Gbps,延迟小于 XNUMX μs。

最新的 InfiniBand 规范称为高数据速率 (HDR)。 该规范于 2017 年推出,现已成为高性能计算的标准。 HDR 的最大带宽为 200 Gbps,延迟小于 XNUMX μs,比 QDR 快五倍。 HDR还具有更高效的编码方案,减少了传输数据的开销。

以下 InfiniBand 规范称为下一个数据速率 (NDR)。 该规范目前正在开发中,预计可提供 400 Gbps 的最大带宽和小于 XNUMX μs 的延迟。 NDR 将使用 PAM4 编码,允许设备之间的距离更长,而不会损失信号质量。

那么,InfiniBand是如何实现低延迟、高性能计算的呢? InfiniBand 通过关键功能实现了这些壮举,包括硬件卸载、远程直接内存访问 (RDMA) 和拥塞控制。

硬件卸载允许 InfiniBand 网络适配器卸载传统上由 CPU 执行的任务,例如校验和计算和消息路由。 这种卸载可以减少 CPU 的工作负载,并为其他作业释放资源,从而提高整体系统性能。

RDMA 允许一个设备上的应用程序直接访问另一设备的内存。 这种直接内存访问绕过了 CPU 和传统网络堆栈,减少了延迟并提高了整体系统性能。 拥塞控制对于管理高性能计算环境中的流量也至关重要。 InfiniBand 的拥塞控制机制可防止网络拥塞并确保数据以尽可能高的速度传输。

推荐阅读: 什么是数据中心网络? 如何管理数据中心网络

InfiniBand 技术彻底改变了超级计算机、存储系统、数据中心和集群的运行方式。 其高速数据传输能力使其成为多个行业的关键解决方案。

InfiniBand 于 1999 年推出,作为并行计算环境的高速互连技术。 它是一种低延迟、高带宽技术,可以在系统之间快速传输大量数据。 InfiniBand 架构使用交换结构拓扑,允许多个主机同时独立地进行通信。 它与以太网和光纤通道等其他竞争技术不同,因为它具有低延迟和高带宽支持。

InfiniBand 是为世界上最快的超级计算机提供动力的技术。 它允许高度并行性,从而可以同时处理大量数据。 InfiniBand 在高性能计算 (HPC) 系统的设计中发挥着核心作用,并用于各种类型的科学研究,如物理、生物学和气象学。 根据排名全球最快超级计算机的 Top500 网站显示,前 70 强中超过 500% 的系统都采用了 InfiniBand 技术。

InfiniBand 技术也是高性能存储系统的重要组成部分。 InfiniBand的高速技术可以实现服务器和存储系统之间的快速数据通信。 低延迟和高带宽对于需要快速访问大量数据的数据密集型应用程序特别有用。 InfiniBand 技术还可以帮助减少数据库应用程序中的存储系统延迟,从而更快地处理查询和事务。

InfiniBand 技术连接数据中心和集群环境中的服务器和其他设备,例如存储系统。 InfiniBand 的高速通信功能使集群能够作为单个实体运行,从而增强需要并行计算的应用程序的性能。 此外,InfiniBand 为虚拟化平台提供可靠且可扩展的互连,从而更有效地利用服务器资源。

InfiniBand 的高带宽和低延迟技术在 HPC 工作负载中发挥着重要作用。 它可以同时处理大量数据,从而提高科学研究应用的性能。 InfiniBand 还用于金融建模、石油和天然气勘探以及其他数据密集型工作负载。

InfiniBand 技术多年来不断发展,从早期的并行计算环境到在 HPC 和数据中心环境中的广泛使用。 最新的 InfiniBand 技术提供每端口高达 400 Gbps 的数据传输速度,从而实现更快的数据处理。 InfiniBand 的低延迟和高带宽特性在新兴的量子计算环境中也特别重要。 该技术可以实现量子处理器和经典计算机之间更快的通信。

InfiniBand 市场的两大领先厂商是 Mellanox Technologies(现为 NVIDIA 的一部分)和英特尔公司。其他著名公司包括 IBM、Cray、Penguin Computer 和 Fujitsu。 据MarketWatch称,18.1年至2021年期间,全球InfiniBand市场预计将以2026%的复合年增长率(CAGR)增长。

自 2000 年代初问世以来,InfiniBand 技术已经取得了长足的进步。 最初设计为服务器集群的高速互连,其功能已经扩展,可以满足广泛的计算应用程序的需求。 本节将讨论该技术的未来趋势及其在现代计算中日益增长的重要性。

多年来,InfiniBand 技术经历了重大改进。 最新版本的 InfiniBand(包括最新的 HDR 200G)提供超快的数据传输速率、低延迟和高带宽性能。 这些改进是通过行业利益相关者、标准化机构和研究团体之间的持续合作实现的。

InfiniBand 技术最重要的进步之一是新接口和连接器的开发。 Mellanox 和 Intel 等供应商推出了适配器和电缆,使 InfiniBand 设备与计算系统的连接变得更加容易。 Mellanox 推出的 M2PCIE3 卡就是新接口的一个很好的例子,它使用户能够将 InfiniBand 设备连接到 PCIe 3.0 插槽。

InfiniBand 因其低延迟和高带宽功能而在高速互连中独树一帜。 其他技术,如以太网和光纤通道,无法与 InfiniBand 的数据传输速率和互连性能相媲美。 InfiniBand 的远程直接内存访问 (RDMA) 使其能够在不使用主机 CPU 的情况下高效地移动数据,从而减少开销并实现更快的数据传输。

低延迟和高带宽在现代计算中至关重要,尤其是在依赖实时数据处理和分析的应用程序中。 InfiniBand 能够在不影响速度或延迟的情况下提供高性能连接,使其成为高性能计算集群、云计算和数据中心中流行的解决方案。

由于对高性能计算和数据处理的需求不断增长,InfiniBand 技术在现代计算中的重要性可能会在未来几年内变得更加重要。 随着物联网、大数据分析和人工智能的兴起,对高带宽和低延迟互连的需求不断增长。

InfiniBand技术的未来可能会出现更多创新,例如更快的数据传输速率、更低的延迟以及机器学习和自动驾驶等领域的新应用。 随着技术的发展,InfiniBand 可能仍将是现代计算基础设施的关键组成部分。

推荐阅读: 数据中心与云

答:Infiniband 是一种用于计算机网络中数据传输的高速互连技术。 它在服务器、存储设备和其他网络资源之间提供高带宽和低延迟通信。

答:与标准以太网相比,Infiniband 提供更高的数据传输速度和更低的延迟。 它特别适合 RDMA(远程直接内存访问)技术,该技术可以实现机器之间的直接内存访问,而无需 CPU 参与。

答:RDMA 代表远程直接内存访问。 它是一种允许数据在两台计算机的内存之间直接传输而无需CPU的技术。 Infiniband 支持 RDMA,可实现快速高效的数据传输。

答:HDR Infiniband(高数据速率)是最新一代的 Infiniband 技术,可提供比前几代更高的带宽。 它支持高达每秒 200 吉比特的数据传输速率。

答:IBTA 代表 InfiniBand 贸易协会。 它是一个开发和推广Infiniband技术的行业联盟。 该联盟与成员公司合作定义和维护 Infiniband 的行业标准。

答:QDR、SDR 和 DDR 是不同代的 Infiniband 技术:

答:Infiniband 使用 RDMA 协议进行数据传输。 RDMA允许数据在两台机器的内存之间直接传输,而不需要CPU的参与,从而实现低延迟和高性能。

答:ROCE(融合以太网上的 RDMA)是一种使 RDMA 技术能够在标准以太网上使用的协议。 它允许使用 Infiniband RDMA 协议通过以太网连接进行高速、低延迟通信。

答:在Infiniband中,队列对(QP)是由发送队列和接收队列组成的通信实体。 它是 Infiniband 结构中数据传输和处理的基本单元。

答:Infiniband 产品的一些示例包括主机通道适配器 (HCA)、交换机、电缆和软件。 这些产品用于构建和部署 Infiniband 网络。